sparse representation의 한계는 강의 초반에 언급되었음

이거 쓸데없이 헷갈렸음 ㅡㅡ;;ㅋㅋ

시그모이드 함수에 대해서 θTx(i) 가 0을 기준으로 양의 방향으로 갈 때 h(x(i),θ) 는 1에 가까워지고, 음의 방향으로 갈 때 h(x(i),θ)가 0에 가까워짐

y 라벨이 1일 때와 0일 때로 나눠 생각해보면 된다

y 라벨이 1인데 예측값이 0에 가까우면 손실은 커지고, y 라벨이 0인데 예측값도 0에 가까워지면 손실은 0에 수렴

생각해보면 매우 간단한 문제..

시그모이드 함수 그래프 그려보면 금방 나온다

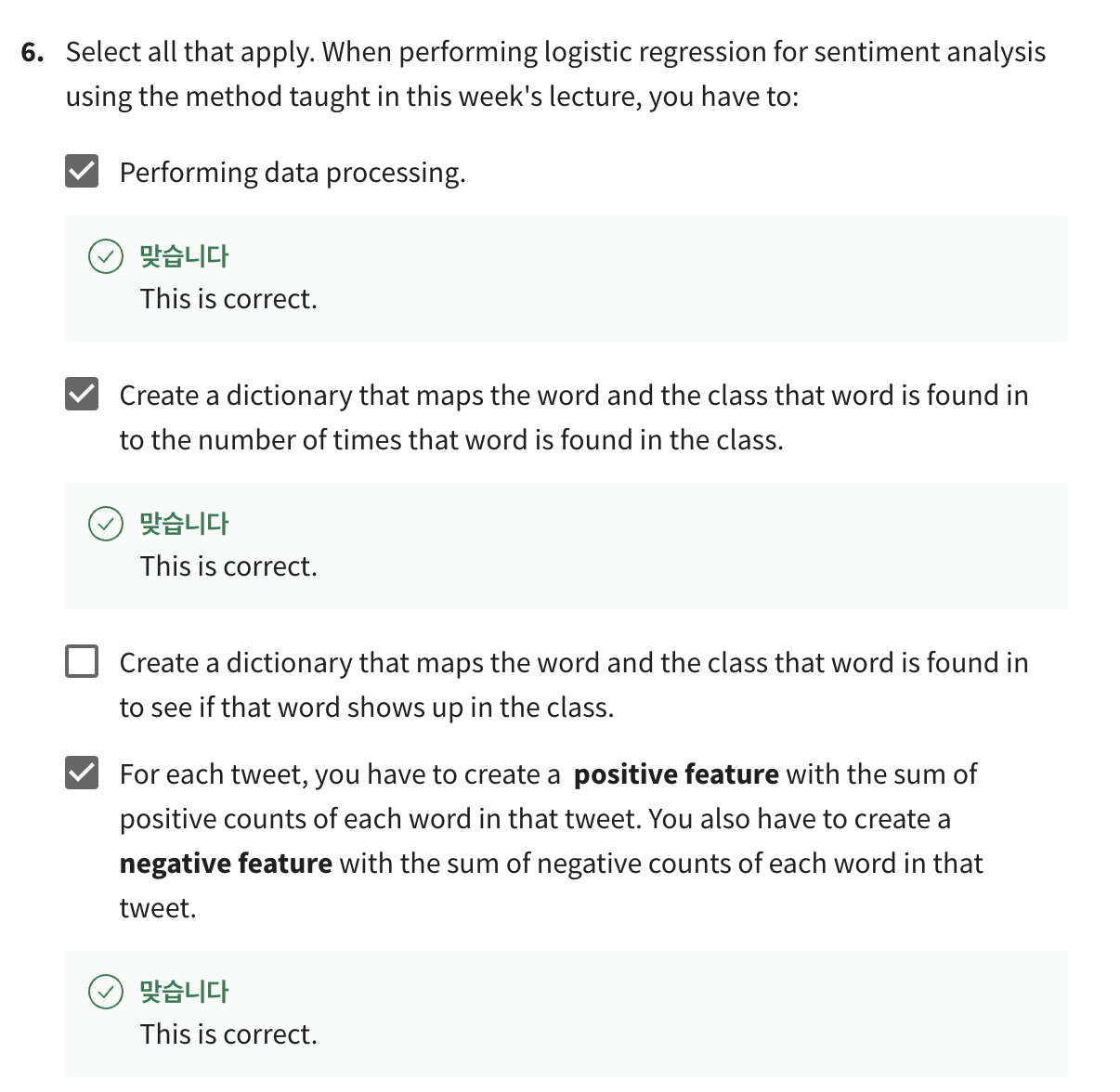

이진 분류를 위한 logistic regression을 할 때 필요한 과정들

요거 급 헷갈려서 컨닝했다

1) 파라미터 초기화

2) 예측

3) 그라디언트 계산

4) 업데이트

라벨이 1인 트윗에 대해 정답을 맞혔다고 가정, 이는 예측값h가 0.5보다 컸음을 의미함

예측값h가 1에 가까울수록 (1-예측값h)는 0에 가까워진다

이거 복수정답인데 하나만 골라서 틀렸음 ㅋ

첫번째 선지도 답이었겠죠?

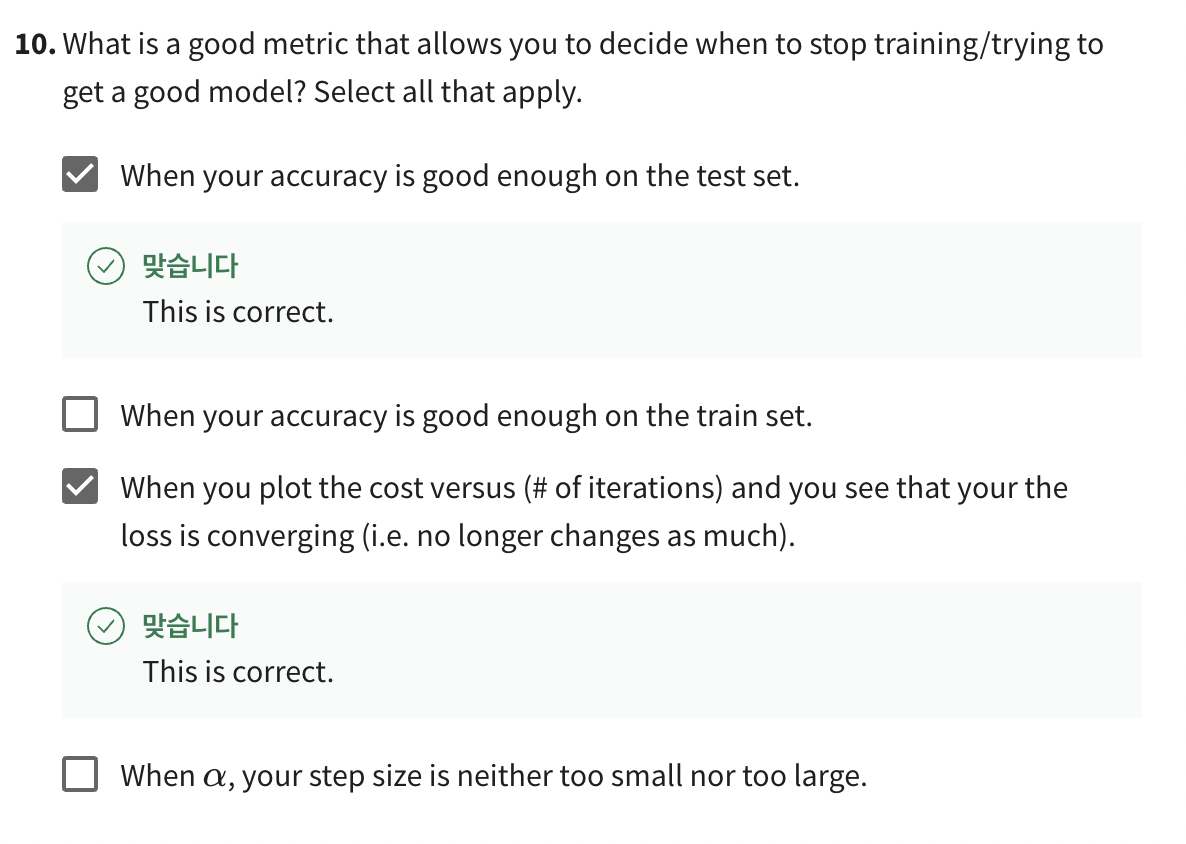

경사하강법 식을 다시 봐본다

검증셋의 적절한 활용